Vmware настройка сети Esxi. Настройка сети хоста Esxi и виртуальных машин.

В данной статье описана настройка сети Esxi, включая настройку адаптеров VMkernel и сетей виртуальных машин VMnetwork.

Итак, мы установили ESXi, развернули виртуальную машину с Vcenter(VCSA 6.5), произвели его первоначальную настройку. Давайте теперь настроим сеть на нашем хосте ESXi.

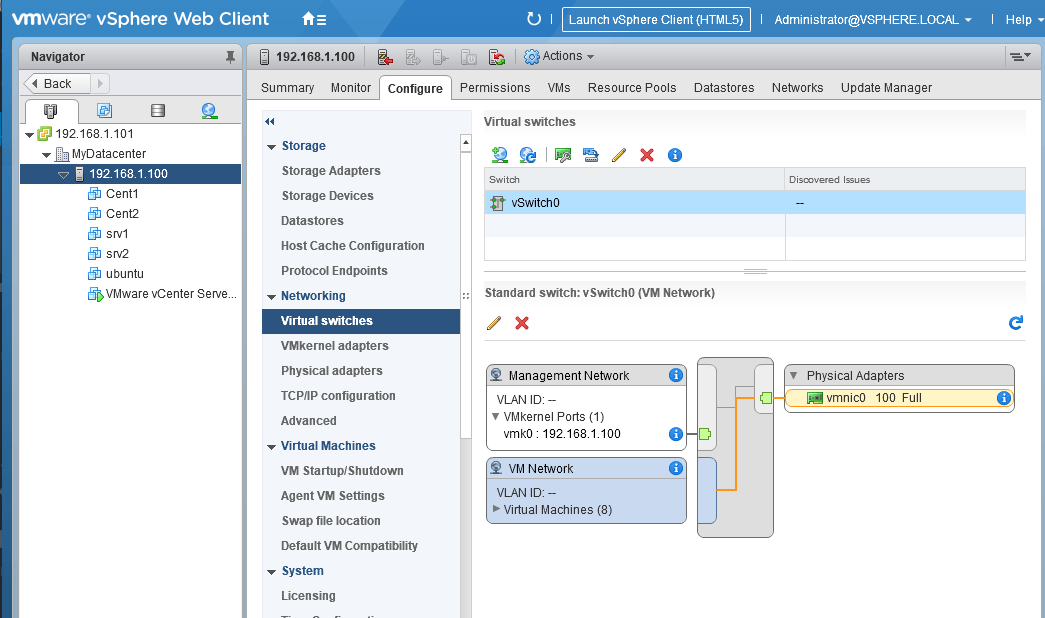

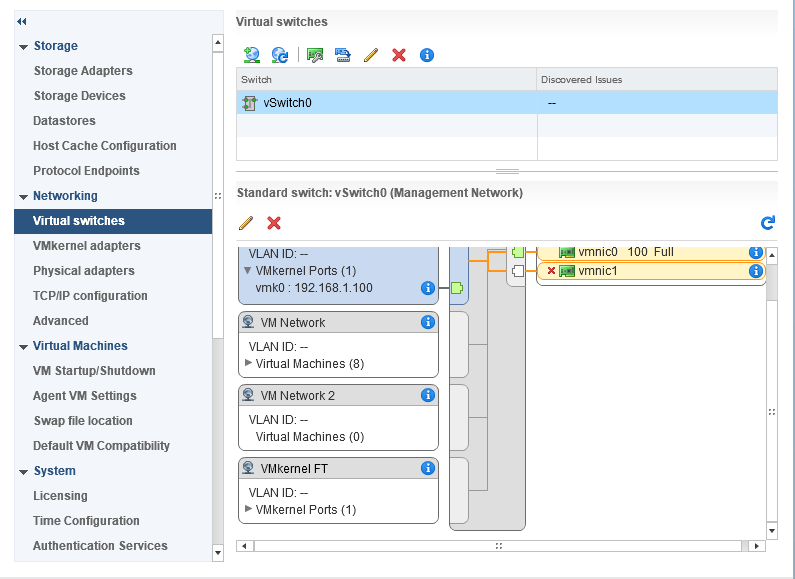

Для этого выбираем наш хост, жмем на вкладку Configure, и в разделе Networking выбираем Virtual Switches.

Поскольку у нас на хосте имеется два сетевых адаптера(как установить драйвер на неподдерживаемую сетевую карту мы рассматривали в статье), давайте добавим нашу сетевую карту в виртуальный свич и настроим так называемый тиминг(объединение сетевых интерфейсов).

Виртуальных коммутаторов на хосте может быть несколько. Если вы хотите, чтобы ваши виртуальные машины находились в изолированной сети, можно создать виртуальный коммутатор, не используя сетевые адаптеры.

Ну а мы рассмотрим настройку обычного виртуального свича.

VMware настройка сети esxi. Настройка виртуального коммутатора.

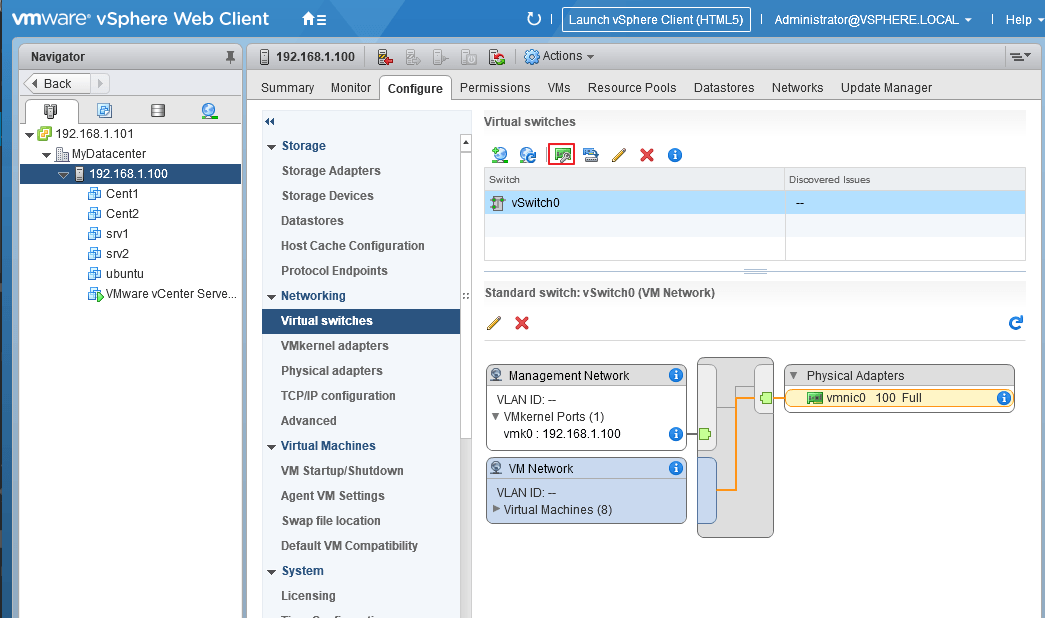

Выбираем наш единственный виртуальный коммутатор и нажимаем на значок сетевой карты

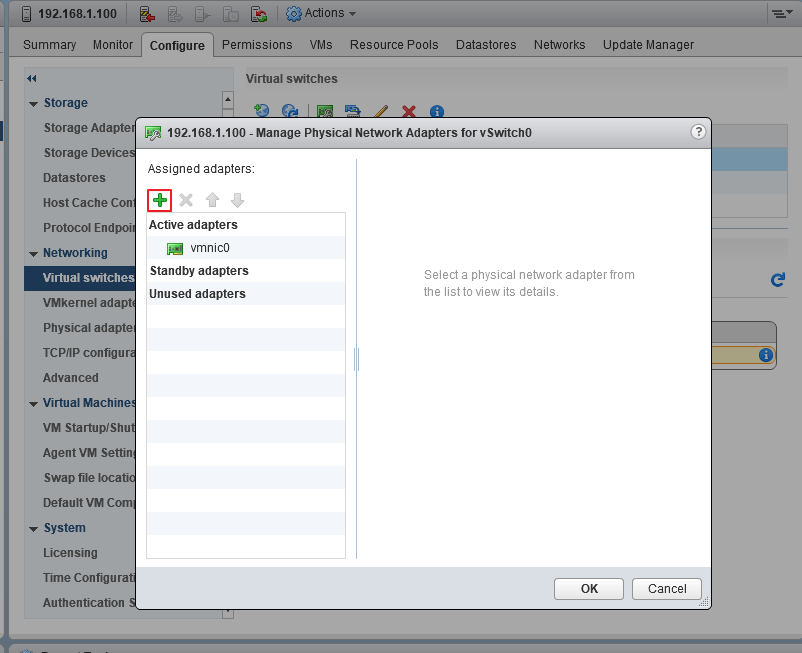

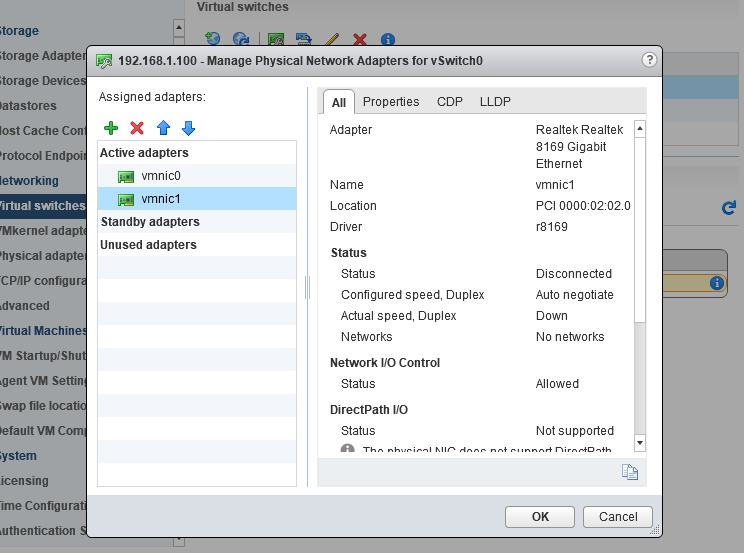

В открывшемся окне видим, что у нас сейчас активен один сетевой адаптер vmnic0. Жмем на зеленый плюс, чтобы добавить второй

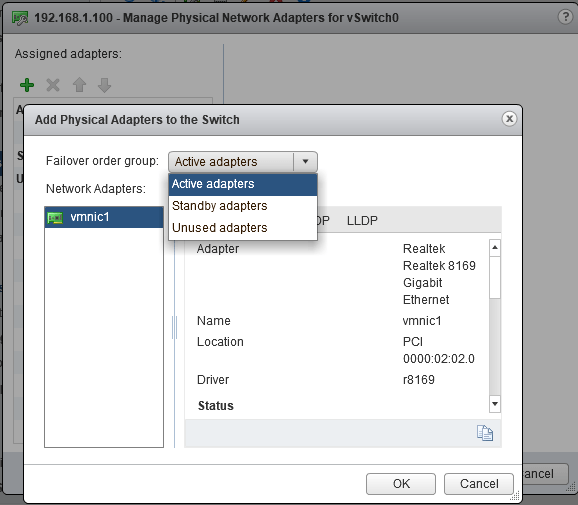

Видим нашу вторую сетевуху, выбираем ее и группу адаптеров, в которую нужно ее добавить(в нашем случае Active adapters).

Active adapters — сетевая карта будет использоваться

Standby adapters — сетевая карта будет задействована в случае выхода из строя основной

Unused adapters — сетевая карта не будет использоваться.

На следующем экране видим, что наши адаптеры находятся в группе активных(можно поменять группу адаптера с помощью синих стрелок, а также удалить адаптер или добавить еще).

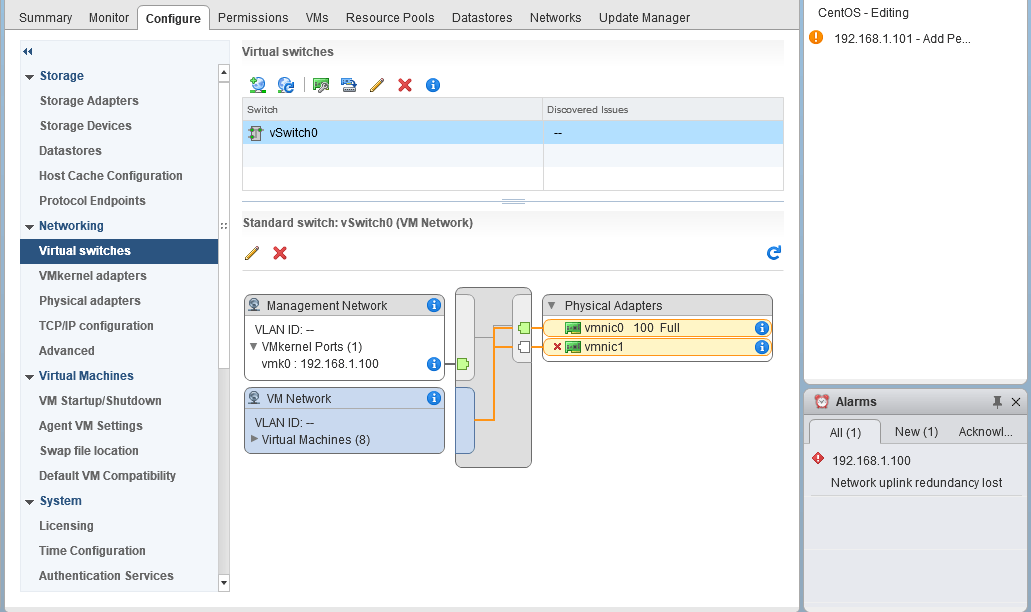

Жмем ОК и видим, что теперь в нашем свиче два сетевых адаптера(у меня подключен только один, поэтому VMware «сигналит», что отказоустойчивость потеряна.

В виртуальных свичах VMware есть сеть для виртуальных машин VM Network(сюда подключаются виртуальные машины) и VMkernel, предназначенный для служебного трафика(Management, VMotion, iscsi и т.п.).

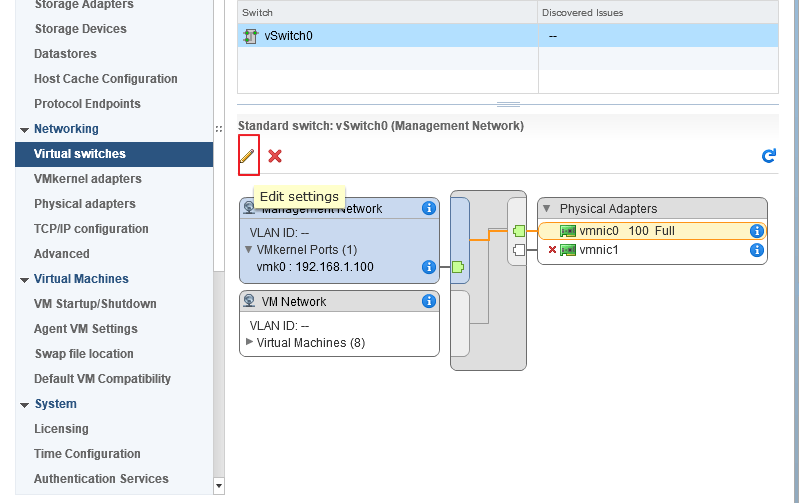

Давайте настроим наш управляющий интерфейс, который используется для управления хостом.

Выделяем окно с заголовком Management Network и нажимаем на карандаш для редактирования.

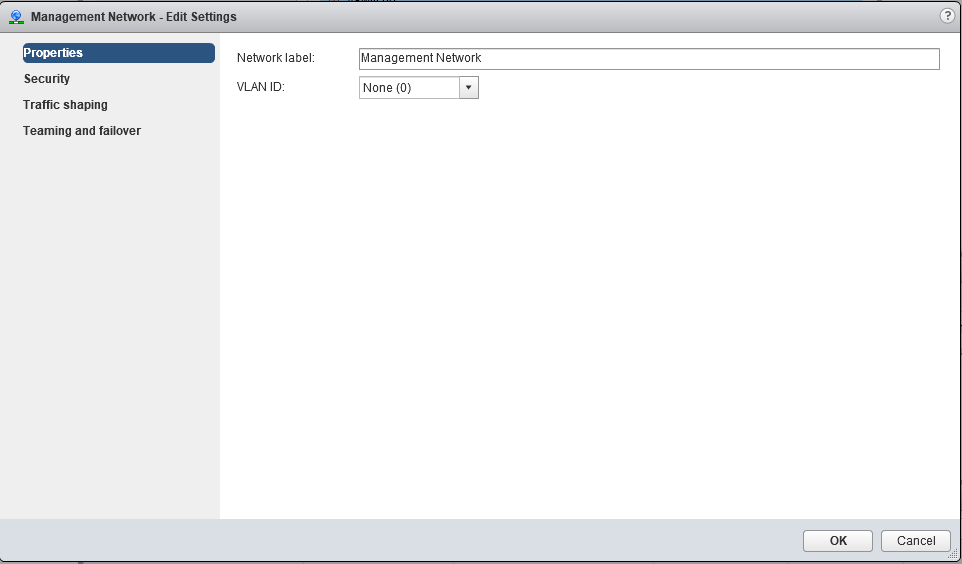

В настройках Management Network вы можете изменить название сети, VLAN(если используется), настройки безопасности, traffic shaping(в стандартном свиче ограничивается только исходящий трафик) и режим файловера и балансировки нагрузки.

Настройки по умолчанию вполне себе работают, поэтому оставим их без изменения. Если вас они не устраивают, можете выставить желаемые настройки(информацию по best practices можно поискать на сайте https://www.vmware.com).

Интерфейсы VMkernel.

Думаю, нужно еще рассмотреть настройки интерфейса VMkernel, используемого для служебных нужд.

Интерфейсов VMkernel может(и должно) быть несколько, чтобы разделить трафик управления от, например, трафика iscsi. Желательно, чтобы это были физически разделенные сети, ну или, хотя бы, на уровне VLANs.

Давайте настроим несколько таких интерфейсов.

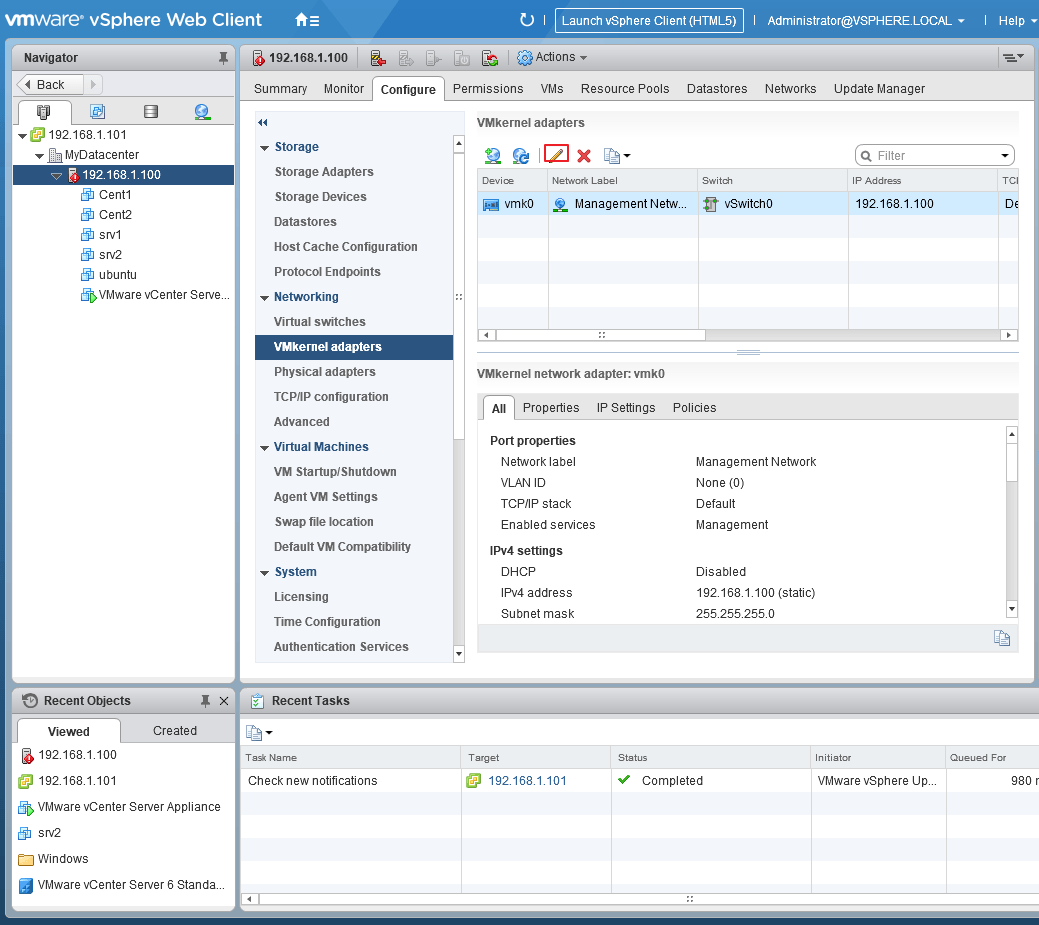

Выбираем в секции Networking вкладку VMkernel adapters, выделяем пока единственный vmk0 и жмем карандаш для редактирования

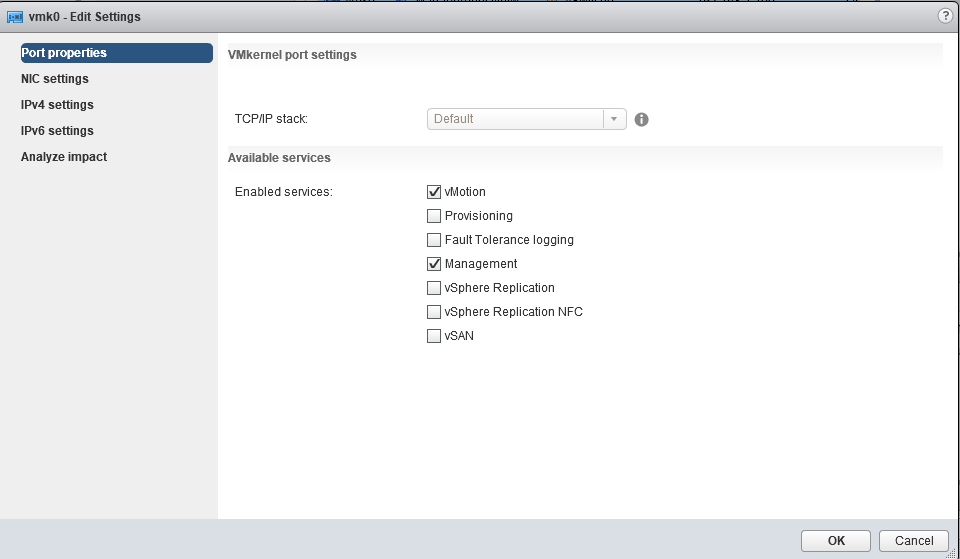

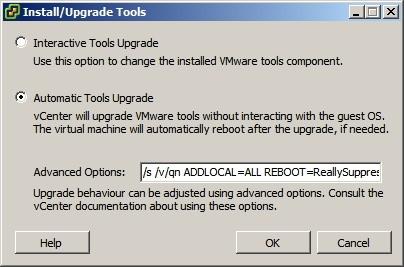

В открывшемся окне на первой вкладке выбираем тип трафика, который разрешен на этом интерфейсе(давайте разрешим здесь еще VMotion — трафик миграции ВМ).

На других вкладках этого мастера можно изменить такие настройки как MTU, настройки IPv4 и IPv6.

После нажатия ОК настройки будут сохранены.

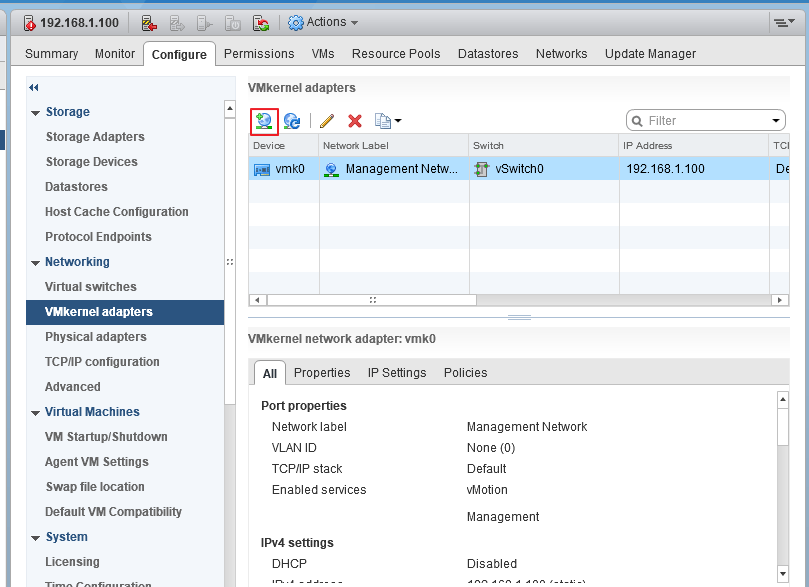

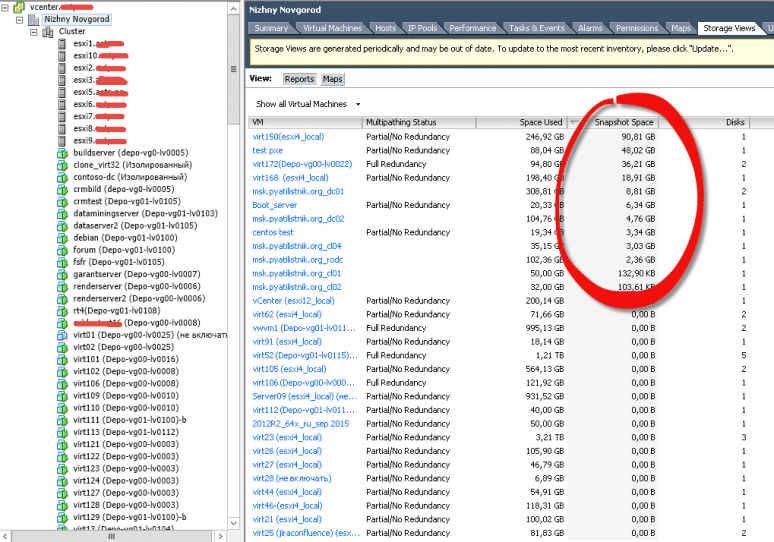

Теперь давайте создадим еще один VMkernel для трафика, например Fault Tolerance. Настройка сети для трафика хранилищ iscsi описана в статье Как подключить iscsi-lun к хосту esxi.

Итак, жмем на глобус с плюсом, чтобы добавить новый адаптер VMkernel

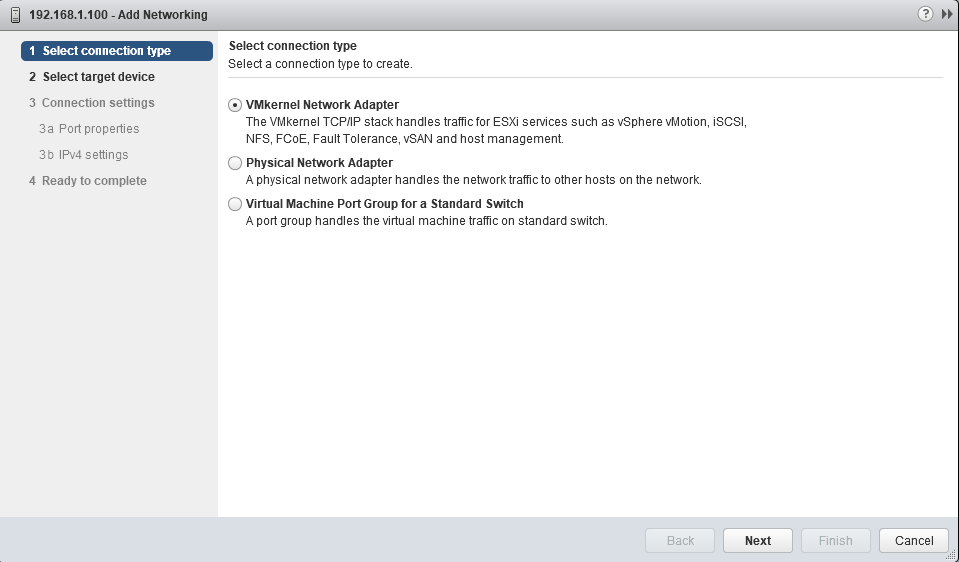

Выбираем тип VMkernel Network Adapter

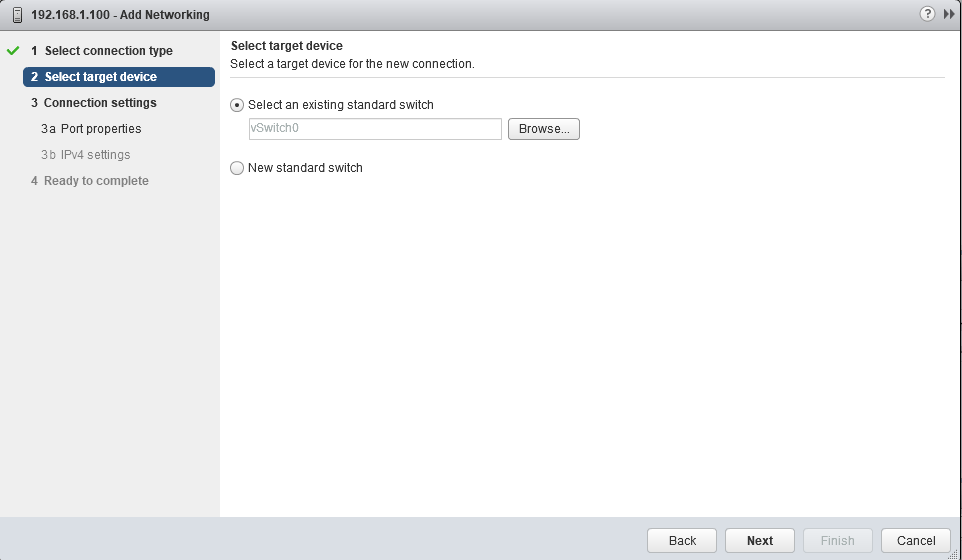

Выбираем, использовать имеющийся или создать новый виртуальный коммутатор(мы выберем наш единственный). Жмем Next.

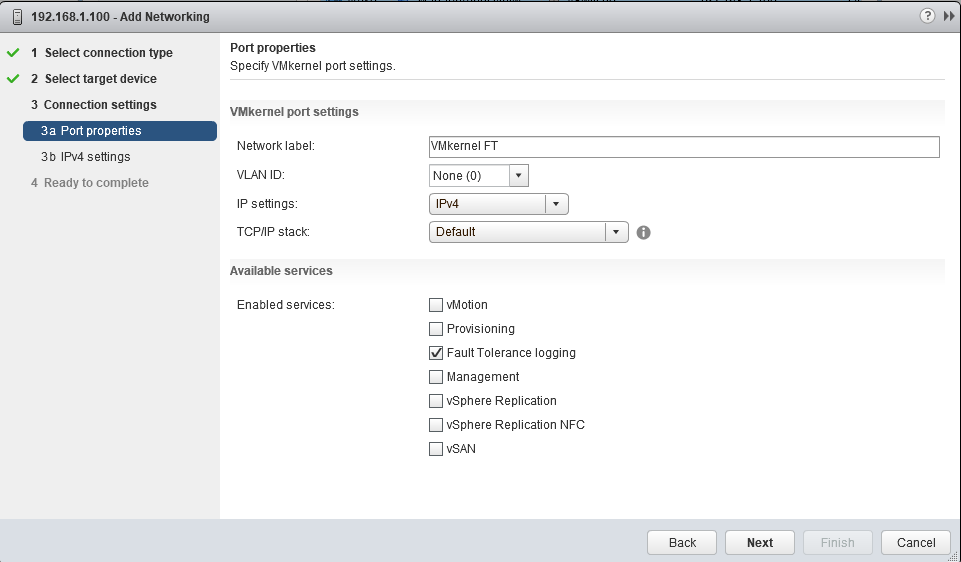

На следующем экране задаем имя нашего адаптера, выбираем какой версии протокол IP будет использоваться и какой трафик

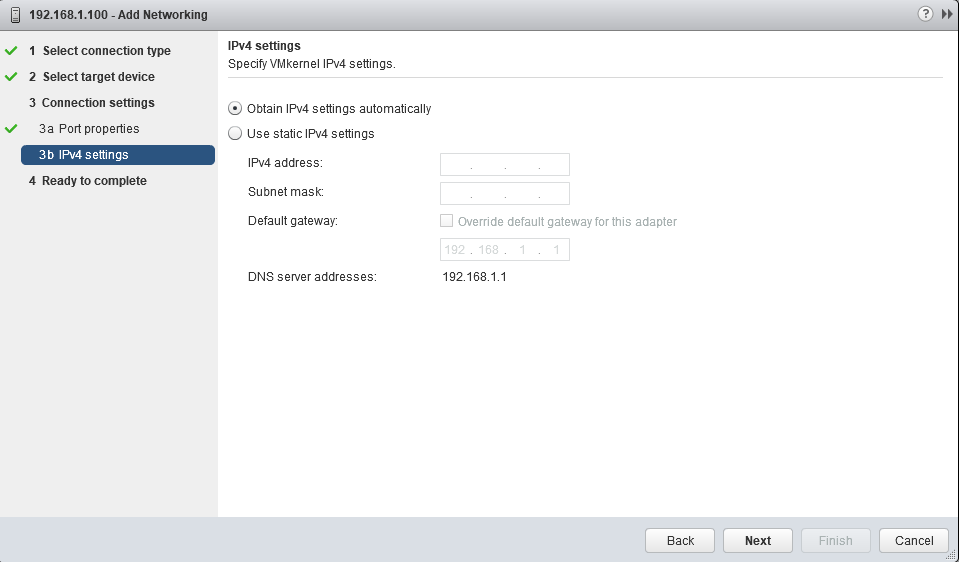

Указываем сетевые настройки(статика или DHCP)

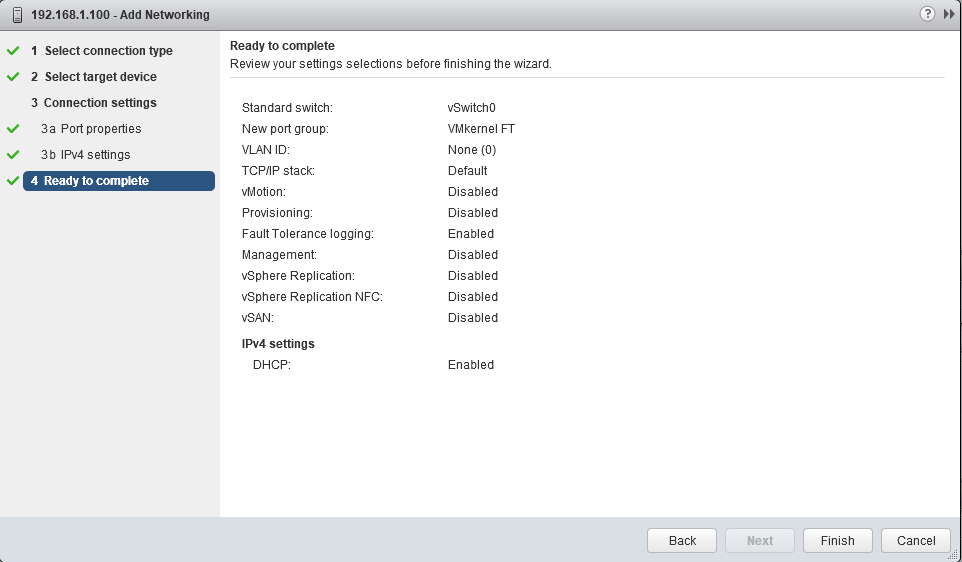

На завершающем экране мастера проверяем настройки и жмем Finish.

Видим, что теперь у нас появился второй VMkernel адаптер, который будет использован для передачи трафика Fault Tolerance logging.

Сети виртуальных машин.

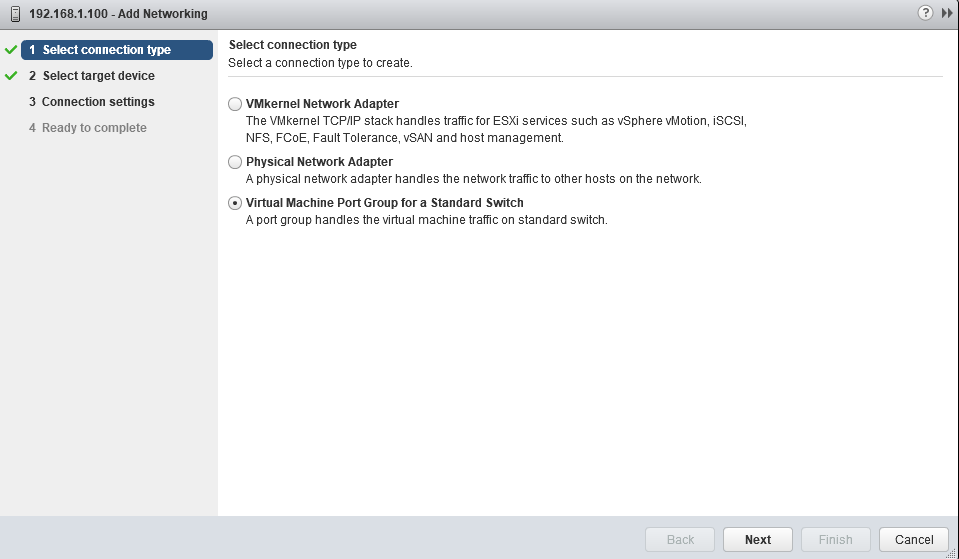

Сеть виртуальных машин создается аналогично, только в мастере нужно выбрать Virtual Machine Port Group

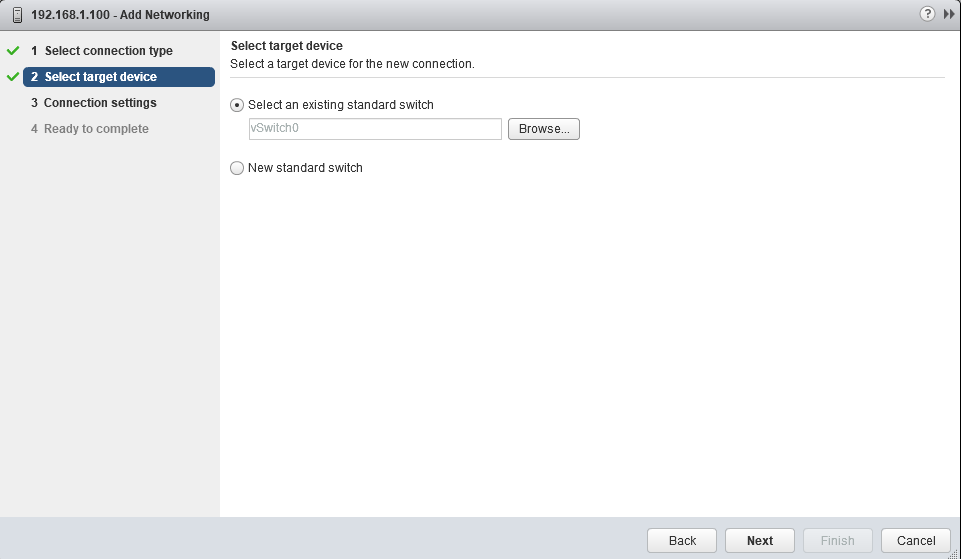

Выбрать или создать VSwitch

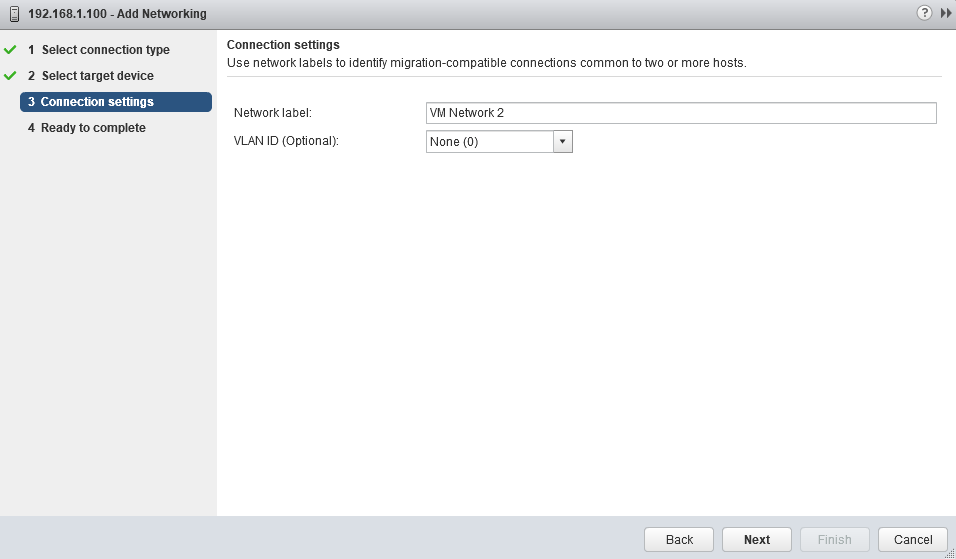

указать название сети и VLAN

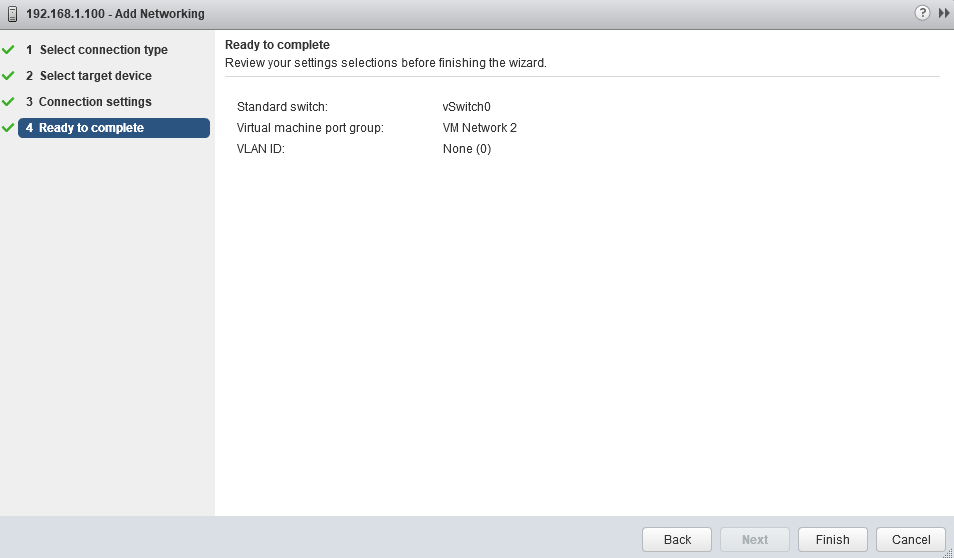

и завершить создание

После этого в нашем виртуальном коммутаторе появится еще одна сеть виртуальных машин и в настройках виртуальных машин станет доступно подключение к этой сети.

Дополнительный виртуальный коммутатор можно создать при создании VMkernel или VM Network. Как я уже говорил, наличие физического сетевого адаптера требуется только, если ВМ должны иметь доступ к внешним ресурсам(находящимся не на данном хосте ESXi).

Ну вот вкратце и всё по настройке сети VMware. Если что-то осталось не рассмотренным или непонятным, пишите в комментариях, — будем дополнять.

Здравствуйте, т. е. У меня должно быть в идеале 3 сетевых физических адаптера на хосте. На 1 настраиваю vmnetwork, на другой iscsi трафик, на 3 vmotion и др. Служебку. Свитч при этом 1 виртуальный? Vlan получается не обязателен?! Не пойму чем отличается physicall adapter от virtual machine port group

Здравствуйте. Сетевых интерфейсов много не бывает)). А по вашему вопросу, физический адаптер — это железная сетевая карта, а порт группа это уже абстракция. Вы можете создать виртуальный коммутатор, используя один или несколько физических интерфейсов или вообще без физических интерфейсов. А уже в виртуальном коммутаторе создавать порт-группы, используемые для различных видов траффика или разделения виртуальных машин на vlans. Я предпочитаю использовать хотя бы два физических адаптера в виртуальном коммутаторе для отказоустойчивости.

Вопрос? С описанным все понятно, а вот есть такая ситуация

Esxi 6.7 одна VM две сетевые карты (физические), по одной сеть работает, а по другой не как не хочет. Виртуальные свичи все , как положено, и карт видны на свичах, а вот вторая сеть не работает

Здравствуйте, Андрей. Из Вашего описания не совсем понятно как у Вас организована сеть, используются ли физические сетевые карты в одном виртуальном свиче или в разных. Если Вы пишете про виртуальную машину, то адаптеры там, скорее всего, виртуальные, а не физические. Проблема может быть уже на уровне операционной системы ВМ(настройки маршрутизации). Если же Вы имели ввиду физические адаптеры хоста, то, возможно, проблема в настройке балансировки нагрузки. В любом случае, спасибо за комментарий. Если нужна помощь, опишите подробнее конфигурацию вашей сети на проблемном хосте.

Добрый день.

Вопрос такой.

Имеется сервер у которого 5 сетевых адаптеров на борту, установлено с завода.

Один из этих адаптеров используется для доступа к внутренней настройке а так же биоса по локальной сети.

А четыре остальных сетевых карты используются для работы в локальной сети.

Скажите пожалуйста как правильнее будет настроить сетевую инфраструктуру, что бы у физических сетевых карт были различные айпи адреса и что бы разные виртуальные машины можно было делить между этими физическими сетевыми картами.

То есть я хочу чтобы например 20 виртуальных машин работающих на разных операционных системах использовали разные физические сетевые карты сервера и тем самым делили трафик и разумеется все в итоге быстрее работало.

Постарался объяснить как можно понятнее, но если что то не так то поправте.

В конечном счете я хочу что бы все четыре гигабитных сетевых карты использовались всегда, для максимальной пропускной способности сети между сервером и основной сетью.

Спасибо за ответ.

Добрый день! Спасибо за комментарий.

Вы можете создать необходимое число виртуальных коммутаторов и сетей для виртуальных машин. Как Вы это будете организовывать-решать Вам. Можно для каждой группы ВМ создать свой виртуальный коммутатор и выделить ему отдельный физический сетевой адаптер сервера. А можно объединить физические адаптеры сервера(все или несколько) в пределах одного виртуального коммутатора и создать несколько сетей ВМ с использованием VLANs(для этого потребуется настройка Вашего сетевого оборудования). Второй вариант мне кажется более предпочтительным, поскольку позволяет делать некоторую балансировку нагрузки. В любом случае, решать Вам, всё зависит от конкретной ситуации и задач. Надеюсь, понятно объяснил). Если остались вопросы-пишите.

Добрый день.

Спасибо вам за ответ.

Смысл я понял, но хочу так сказать проконсультироваться технически.

Тут не нашел функции прикрепить скриншот того как сейчас у меня выглядит виртуальный коммутатор на esxi 6.7

Скажите а как тогда этот коммутатор будет представлен в моей ЛВС в плане адресов? ( у всех этих 4х сетевых карт будет один и тот же адрес или четыре разных адреса ? )

И если при настройке в начале самого гипир визора я настроил айпи адрес, но только один, потому что я не нашел где можно еще настроить адреса других сетевых карт.

Я вижу что линк есть на всех сетевых картах, но мне хочется понять механизм настройки айпи адресов на этих сетевых картах.

Если можно как то с вами через эл. почту списаться или может вацап то напишите пожалуйста на мою почту, она у вас есть я ее вводил при написании сообщения вам.

Спасибо за ответ

IP адреса в виртуальном коммутаторе назначаются интерфейсам VMKernel, а не физическим сетевым картам. Подробнее написал Вам на почту.

Вас понял.

Спасибо вам большое.

Буду читать почту

Добрый день

Скажите а если физических сетевых карты 4 штуки то у них же должны быть так или иначе у каждой свой айпишник ?

Я просто не могу понять до конца, если VMKernel это физический интерфейс представленный в ESXi то как я могу каждой из этих 4х сетевых карт выдать свой айпишник ?

Спасибо за письмо на почту я его прочитал, но все равно до конца не понял.

Если вам не удобно в коментарии то может вам на эл.почту можно написать и приложить скриншоты ?

Спасибо вам за помощь, очень полезный сайт

Добрый день.

Написал вам вопрос по сети на эл. почту.

Спасибо вам и вашему сайту.

День добрый, а как организовать след.

Есть 10.1.14.0 и 10.5.14.0 сети, одна как менеджмент-работает без проблем.

Имеется 2 вирт машины, обе получают сеть 10.1.14.0

Нужно на вторую ,ТОЛЬКО, машину добавить сеть 10.5.14.0

Добрый день.

Добавьте на вторую виртуальную машину сетевой адаптер и подключите его к нужной сети.

Добрый день.

А можно мне тоже на почту написать как организовать доступ виртуальной машины в интернет, но ограничить доступ Management Network только с физического интерфейса который смотрит в локальную сеть? У меня примерно такая же задача как и у комментатора выше, я примерно понял что нужно создать виртуалный коммутатор и привязать его к сетевому интерфейсу который смотрит в интернет, но у меня не получается на VMkernel удалить Managament Network.

У меня две физических интерфейса и одна Виртуальная машина, хочу чтобы по одному кабелю она смотрела в интернет, а по второму смотрела в локальную сеть. Как ограничить доступ к управлению гипервизору со стороны интернета?

Здравствуйте.

Под «смотрит в интернет» вы имеете ввиду, что на интерфейсе «белый» IP-адрес? Тогда Management с него действительно лучше убрать. Для настройки управляющего интерфейса на сетевом адаптере, смотрящем в локальную сеть, создайте привязанный к нему виртуальный коммутатор, а уже на нем создайте интерфейс VMkernel и разрешите управляющий траффик. Это можно сделать и в локальной консоли хоста ESXi(даже непосредственно после установки ESXi), указав какой из физических адаптеров будет использоваться для управления. А подключать виртуальные машины Вы, в любом случае, будете к VMNetwork-интерфейсу нужного виртуального коммутатора, а не к VMKernel. Что касается ограничения доступа к управлению, можете разрешить доступ с нужных вам адресов в настройках firewall.

Надеюсь, я ответил на ваши вопросы. Если нужна дополнительная помощь — напишите, отвечу на почту.

Доброго времени суток! К примеру взять пару физических серверов, с разным количеством физических карт. Соединены через vCenter. У одного 2 сетевухи и у другово 4. Нужно сделать 2 для белого ip, 2 для локального. Нужно создать 2 виртуальных сетевых карт, чтобы первый сервер не остался в стороне? vSwitch0 и vSwitch1 или vmnic0,vmnic1… Спасибо. Правильно описать возникают сложности, когда не понимаешь)

Здравствуйте! Не совсем понятна задача из вашего комментария. Вам в любом случае нужно создавать виртуальные свичи на ваших хостах Esxi. Количество физических сетевых адаптеров в них может быть различное. А IP-адреса будут назначаться на интерфейсах vmk или vmnic, в зависимости от того, нужны они хостам esxi или виртуальным машинам на них.

Здравствуйте!

В VMWare ESXi — 3 машины — все в разных подсетях.

На одной машине увеличили мощность проца и память.

После этого машина выпала с сети — не пингуется.

Пробовал заново создать — на виртуальном коммутаторе — VLAN.

Подскажите как поднять машину?

Здравствуйте! Вообще, увеличение ресурсов виртуальной машины не должно вызывать сетевых проблем. Проверьте есть ли линк внутри виртуалки, доступен ли шлюз по умолчанию, подключен ли интерфейс в виртуальный коммутатор(на esxi). Также, проблема с пингом в разных подсетях может быть связана с маршрутизацией трафика.

Добрый день! Помогите разобраться с одним вопросом: мне надо сделать на базе EXSi систему мониторинга трафика, а именно связку из 3х, которая будет передавать трафик в 4ую, подключенную через отдельный сетевой адаптер. Это делается для того, чтобы была возможность мониторинга трафика 3х первых машин и статистика передавалась наружу по второму физическому адаптеру. Пытаюсь реализовать подобное через подключение одного виртуального свича в другой но никак не могу понять как именно это делать

Здравствуйте!

К сожалению, не знаю, как точно сделать то, что Вам нужно, но, думаю, как минимум, нужен Distributed Switch или делать это уже на уровне физического сетевого оборудования.

у меня появилась мысль, сделать в одном виртуальном свиче 3 виртуалки с физическим адаптер, в другой виртуальный свич поставить отдельную 4ую виртуалку с двумя физическими подключениями и обычным патчкордом соединить оба виртальных свича.

Думаю, разумнее будет разместить 3 виртуальных машины в одном виртуальном свитче, а 4-ю подключить одним виртуальным адаптером в этот же свитч, а другим в отдельный. Надеюсь, я правильно понял вашу схему.

Приветствую вас.

Сейчас подкинули сервера в датацентре с Загадкой от Жака Фреско.

Итак имеется 3 сервера 01,02,03.

В 01(2 сетевых адаптера) приходит интернет(Резерв), и вторым интерфейсом он смотрит в 02.

02(4 сетевых адаптера), подключён в интернет(основной), в 01 и слот3 в 02(Этот-же сетевой интерфейс объявлен управляющим).

03(3 сетевых адаптера), подключен в 02.

Во первых, я по непонятной причине, вытащив кабель 02-03 из 03, и подключив его к ноутбуку не смог получить доступа к 02 хосту… Даже присваивал ноутбуку айпи хоста 03, бестолку…

И Второй вопрос, Перенес машину с хоста 02 на хост 01. Добавил на физическом сетевом интерфейсе виртуальный, с таким-же именем и параметрами как и на 02. В Итоге перенесенную машину не видно(не пингуется и так далее с 02,03…

Вы мне очень поможете если расскажите по шагам как сделать так, что бы трафик iscsi (все виртуальные машины лежат на внешнем накопителе) шел с одного физического интерфейса, а управление и виртуальные машины были подключены ко второму сетевому адаптеру. т.е. трафик не должен пересекаться.

я попытался сделать так:

1. отключил второй физ адаптер от виртуального свяча в надежде создать новый свич и добавить в него отсоединенную карту. но сервер завис на операции «конфигурирование сетевого…» и больше я не смог получить доступ к vmware.

теперь боюсь экспериментировать.

vmware 6.5 используется.

Спасибо за статью.

Андрей Сергеевич, приветствую!

Честно говоря, я мало что понял из Вашего комментария по организации сетевых подключений на этих серверах. Почему сервера интерфейсами смотрят друг в друга? Может, быть имеет смысл организовать сеть с использованием коммутаторов? И не совсем понятно, почему у Вас управляющий интерфейс есть только на одном из серверов(или Вы так написали). По вопросу недоступности машины после переноса: обычно такое бывает, когда сети виртуальных машин имеют разные названия или различаются настройки(например VLAN). Также проверьте в настройках ВМ, чтобы сетевой интерфейс ВМ был подключен к сети виртуальных машин.

Степан, приветствую!

Исходя из описания, Вы попытались сделать правильно. Вам нужно сделать два виртуальных свича(по одному физическому адаптеру на каждом). На одном свиче настроить трафик iscsi, а другой использовать для управления и траффика виртуальных машин. Для этого нужно создавать интерфейсы vmkernel(по крайней мере, для нового виртуального свича с iscsi), как описано в статье. Почему у Вас пропал доступ при попытке удалить интерфейс, точно не скажу(вероятно Вы отключили интерфейс, который использовался). Посмотрите в каком режиме настроены эти интерфейсы в виртуальном свиче. Попробуйте сначала перевести один из интерфейсов в Unused. В любом случае, спасибо за комментарий. Если останутся вопросы, пишите.

И снова здравствуйте. Если-б в моём распоряжени был коммутатор, у меня-б не возникло проблем от слова совсем. Так как все серваки жили б в единой подсети. Учитывая что это делал не я и пояснительной стребовать не от кого — приходится решать загадку от Жака Фреско…

Дейвствительно сейчас физические сети хостов(Они-же сети управления) выглядят как 20.10.8.250(для хоста 01) 20.10.10.251(для хоста 02) и 20.10.10.252(для хоста 03). И Всё это управляется через Вмцентр живущий внутри Второго хоста 20.10.10.253(Или подрубатся к каждому хосту по айпи). Короче всё максимально запутано… Все это ещё осложняется Керио.

Конечная цель которую я преследую. Нужно остановить сервак, засетапить по новой ESXI, Желательно вытянуть двдюк и поставить оптибей на 12мм. Ибо Флешка на которую впихнули ESXI бэкапится как 380 мб образ/умерла, вытянуть обычные диски в рейде, поставить ссд. Рапихать серваки обратно. Если есть возможнсть как-то вытащить настройки хоста и подбросить их в другую флешку — буду признателен.

Здравствуйте! Если я правильно понял, Вам нужен бэкап конфигурации хоста ESXi. Посмотрите статью по бэкапу конфигурации от VMware.

Добрый день. Так же прошу помощи в правильной реализации сети. Есть 1 физический сервер с 2 физическими адаптерами. Будет установлен esxi. На нём будет развёрнут Kerio Control. В esxi будет заходить 2 физических линка в 1 и 2 физическую сетевую соответственно. В 1 будет интернет провайдер, в 2 в общую LAN для раздачи интернета всей сети. Как правильно настроить эти линки для виртуалки Kerio?

Сам себе отвечу. Сначала создаем еще 1 свитч, называем его например именем провайдера (у меня это I-net), привязываем к нему адаптер провайдера. Потом создаем новый Port Groups (называем его например Internet) и привязываем к нему уже нашbй новый свитч I-net. А уже потом в виртуалке добавляем новую сетевую карту и из списка выбираем новый порт групп Internet.